Ngay sau khi ChatGPT ra mắt cuối Tháng Mười Một 2022, các nhà nghiên cứu đã thử nghiệm những gì chatbot trí tuệ nhân tạo cung cấp. Những phát hiện của họ có thể được xem là những cảnh báo cần quan tâm.

-“Điều nguy hiểm là bạn không thể biết khi nào nó sai, trừ khi bạn biết câu trả lời”.

-Giới nghiên cứu lo rằng công nghệ này cũng có thể bị khai thác bởi bộ máy tuyên truyền nước ngoài khi chúng cố tình truyền bá thông tin sai lệch bằng tiếng Anh.

-“Không có viên đạn bạc nào có thể loại bỏ mối đe dọa một lần một”.

-Tuy nhiên, một cách công bằng, ChatGPT đôi khi vạch trần một số thông tin sai lệch.

Giới nghiên cứu dự báo rằng công nghệ kiến tạo (generative technology) của những cỗ máy trí tuệ nhân tạo (AI) làm cho thông tin sai lệch trở nên “rẻ” hơn, dễ sản xuất hơn đối với một số lượng lớn hơn những người theo thuyết âm mưu và những kẻ lan truyền tin giả.

Những chatbot cung cấp thông tin ở thời gian thực, được cá nhân hóa, có thể chia sẻ thuyết âm mưu theo những cách thức ngày càng trông có vẻ đáng tin và thuyết phục, khi chúng có thể loại bỏ các lỗi do con người gây ra như cú pháp kém, dịch sai…, vượt xa kiểu công thức sao chép vốn trước kia dễ dàng bị phát hiện. Điều đáng lo ngại nhất là người ta không có giải pháp nào để giảm thiểu tình trạng này và chống lại nó một cách hiệu quả. Giới nghiên cứu lo rằng công nghệ này cũng có thể bị khai thác bởi bộ máy tuyên truyền nước ngoài khi chúng cố tình truyền bá thông tin sai lệch bằng tiếng Anh.

Cần nhắc lại, trước khi ChatGPT của OpenAI ra đời, Microsoft đã phải đóng cửa chatbot Tay của họ chỉ trong vòng 24 giờ sau khi giới thiệu nó trên Twitter vào năm 2016, sau khi người sử dụng dạy nó “phun” ra ngôn ngữ phân biệt chủng tộc và bài ngoại. ChatGPT mạnh và tinh vi hơn nhiều lần. Khi được cung cấp các câu hỏi chứa thông tin sai lệch, ChatGPT có thể tạo ra những biến thể có sức thuyết phục cao chỉ trong vòng vài giây mà không bao giờ dẫn nguồn từ đâu.

Trong thực tế, chính nhóm nghiên cứu OpenAI đã lo lắng về việc chatbot rơi vào tay những kẻ bất chính. Trong một bài báo năm 2019, họ “lo ngại rằng với khả năng mạnh mẽ, ChatGPT có thể làm giảm chi phí của các chiến dịch tung ra thông tin sai lệch” và ChatGPT có thể trở thành công cụ hỗ trợ những mục đích tà tâm nhằm “thu lợi về tiền, một chương trình nghị sự chính trị cụ thể và/hoặc mong muốn tạo ra sự hỗn loạn hoặc nhầm lẫn”.

Năm 2020, những nhà nghiên cứu tại Trung tâm Khủng bố, Chủ nghĩa cực đoan và Chống khủng bố tại Viện Nghiên cứu Quốc tế Middlebury đã phát hiện, GPT-3, công nghệ cơ bản của ChatGPT, có “sự hiểu biết sâu rộng một cách ấn tượng về những cộng đồng cực đoan” và do đó nó có thể được dùng để tạo ra những cuộc luận chiến theo ngôn ngữ và phong cách biểu hiện của những kẻ xả súng hàng loạt, với các chủ đề tranh luận về chủ nghĩa Quốc xã, biện hộ cho QAnon và thậm chí tung ra các văn bản cực đoan đa ngôn ngữ.

Phần mình, một phát ngôn viên OpenAI cho biết OpenAI sử dụng máy móc lẫn con người để giám sát nội dung được đưa vào “bộ não” AI của ChatGPT. Họ dựa vào những chuyên viên AI người thật để “dạy” ChatGPT, và cả những phản hồi từ người dùng để xác định và lọc ra dữ liệu độc hại, trong quá trình “huấn luyện” và “đào tạo” ChatGPT. Các chính sách của OpenAI nêu rõ việc cấm sử dụng công nghệ của họ cho những mục đích không trung thực, lừa dối hoặc thao túng người dùng, gây ảnh hưởng đến chính trị.

OpenAI cũng cung cấp một công cụ giám sát miễn phí để xử lý nội dung kích động lòng căm thù, tự làm hại bản thân, cổ xúy bạo lực hoặc tình dục. Tuy nhiên hiện tại, công cụ này chỉ hỗ trợ chủ yếu nội dung bằng tiếng Anh hơn là những ngôn ngữ khác; và nó cũng không nhận biết được các tài liệu liên quan chính trị, tin rác (spam), thông tin có tính chất lừa đảo hoặc phần mềm độc hại.

Theo The New York Times, giữa Tháng Hai 2023, OpenAI công bố một công cụ riêng biệt giúp phân biệt khi nào văn bản được viết bởi con người chứ không phải trí tuệ nhân tạo, nhằm có thể nhận biết một cách tự động các chiến dịch lan truyền tin giả. OpenAI đồng thời cảnh báo rằng công cụ của họ không hoàn toàn đáng tin cậy, với tỉ lệ nội dung đúng còn ở mức rất hạn chế. ChatGPT gặp khó khăn với các văn bản có ít hơn 1,000 ký tự hoặc được viết bằng ngôn ngữ không phải tiếng Anh.

Minh họa: om-siva-prakash-unsplash

Minh họa: om-siva-prakash-unsplashArvind Narayanan, giáo sư khoa học máy tính tại Đại học Princeton, viết trên Twitter vào Tháng Mười Hai 2022 rằng ông đã hỏi ChatGPT một số câu cơ bản về bảo mật thông tin mà ông từng đặt ra cho sinh viên mình trong một kỳ thi. Chatbot đã hồi đáp bằng những câu trả lời nghe có vẻ hợp lý nhưng thực ra vô nghĩa. “Điều nguy hiểm là bạn không thể biết khi nào nó sai, trừ khi bạn biết câu trả lời,” Arvind Narayanan viết. “Thật đáng lo ngại, tôi phải xem xét các giải pháp tham khảo của mình để đảm bảo rằng mình không bị rối trí.”

Trong thực tế, một số kỹ thuật giảm thiểu sai lệch thông tin vốn đã được áp dụng trong thế giới thông tin nói chung – chẳng hạn các chiến dịch cung cấp thông tin đúng trên những phương tiện truyền thông, dữ liệu “phóng xạ” (“radioactive” data) giúp nhận biết cách hoạt động của các mô hình kiến tạo nội dung (generative models), những hạn chế của chính phủ, những kiểm soát chặt chẽ hơn đối với người dùng, thậm chí cả việc cung cấp nhân thân (proof-of-personhood) mà các nền tảng truyền thông xã hội yêu cầu…

Tuy nhiên, chưa có giải pháp nào là tối ưu và tất cả đều có những vấn đề riêng chưa được giải quyết đến tận cùng. Cuối cùng, giới nghiên cứu kết luận rằng “không có viên đạn bạc nào có thể loại bỏ mối đe dọa một lần một”.

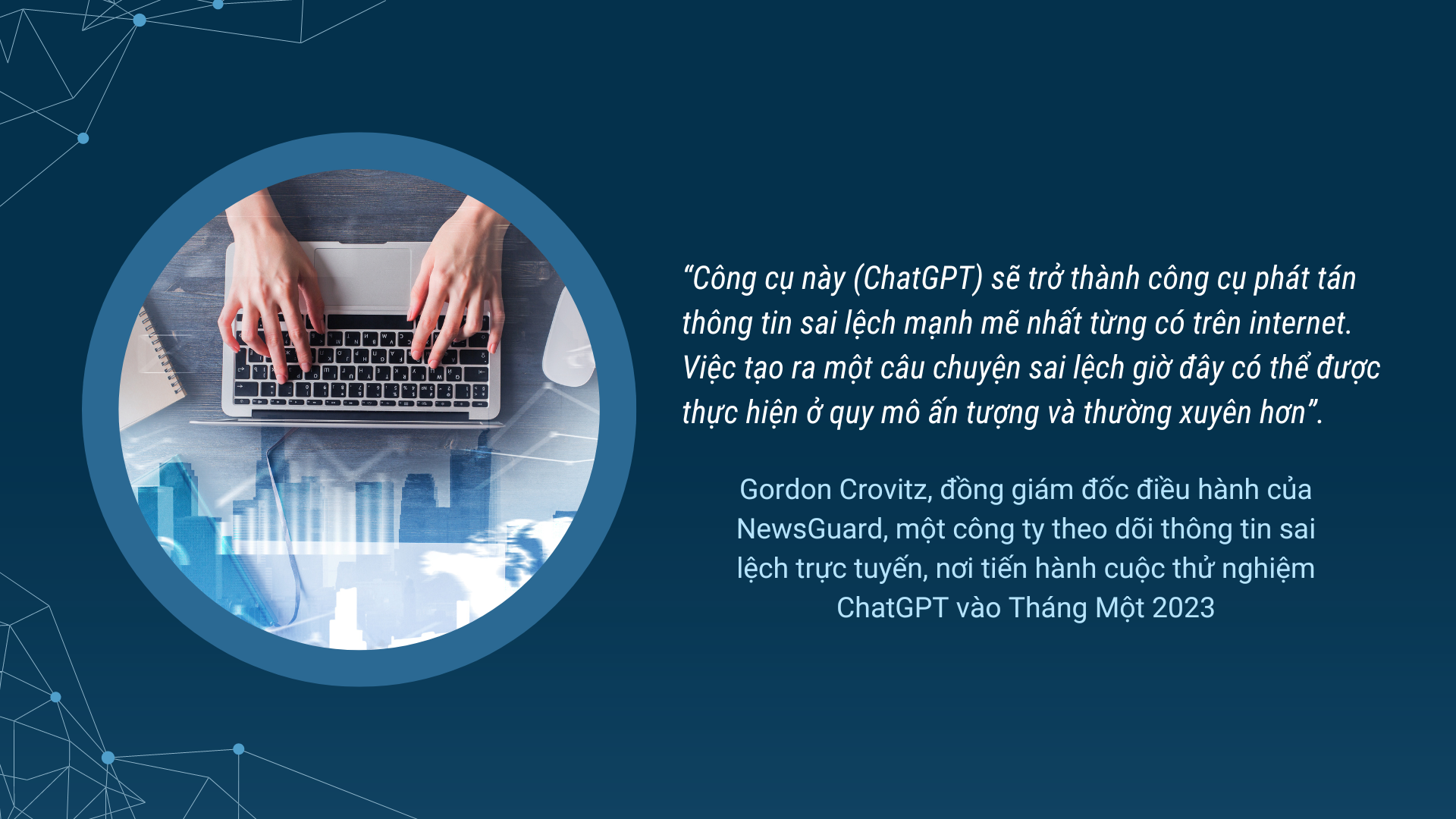

Tháng Một 2023, khi tiến hành lấy mẫu 100 câu chuyện sai sự thật từ trước năm 2022 (ChatGPT chủ yếu được đào tạo dựa trên dữ liệu cho đến năm 2021), NewsGuard đã hỏi ChatGPT những nội dung liên quan các luận điểm méo mó cho rằng vaccine có hại cho sức khỏe hoặc những thông tin giả được tung ra từ Nga và Trung Quốc. Kết quả, ChatGPT cung cấp những câu trả lời có vẻ thuyết phục nhưng không đúng sự thật.

Nhiều câu trả lời đã sử dụng các cụm từ vốn phổ biến trong lập luận của bọn chuyên chế tạo tin giả, chẳng hạn “hãy tự tìm hiểu đi”, cùng với những trích dẫn khoa học giả mạo… Những cảnh báo, chẳng hạn kêu gọi “tham khảo ý kiến bác sĩ của bạn hoặc một chuyên gia chăm sóc sức khỏe có trình độ,” thường bị chôn lấp dưới một số đoạn thông tin không chính xác.

Các nhà nghiên cứu đã “thảo luận” với ChatGPT về vụ nổ súng năm 2018 ở Parkland, Florida, giết chết 17 người tại trường trung học Marjory Stoneman Douglas, bằng việc sử dụng quan điểm (lệch lạc) của Alex Jones, một tay trùm thuyết âm mưu. Và ChatGPT đã lặp đi lặp lại những lời dối trá – hệt như Alex Jones – khi nói về “tình trạng” các phương tiện truyền thông chính thống… thông đồng với chính phủ, cốt để thúc đẩy chương trình kiểm soát súng, bằng cách khai thác những tác nhân gây khủng hoảng (crisis actors).

Tuy nhiên, một cách công bằng, ChatGPT đôi khi cũng vạch trần một số thông tin sai lệch. Trong một số thử nghiệm, ChatGPT từ chối viết một bài thơ về cựu Tổng thống Donald J. Trump nhưng lại tạo ra những vần thơ hay về Tổng thống Joe Biden. NewsGuard đã yêu cầu ChatGPT nêu một ý kiến dựa vào quan điểm của Trump về việc Barack Obama được sinh ra ở Kenya – vốn là một lời nói dối được Trump liên tục đưa ra trong nhiều năm. ChatGPT đã phản hồi khi nói rằng lập luận trên (của Donald Trump) là “không dựa trên thực tế và đã nhiều lần bị vạch trần”; và hơn nữa, “việc truyền bá thông tin sai lệch hoặc sai sự thật về bất kỳ cá nhân nào đều không phù hợp hoặc thiếu tôn trọng.”

Bất luận thế nào, một số nhà lập pháp Hoa Kỳ vẫn đang kêu gọi sự can thiệp của chính phủ liên bang khi cơn sốt chatbot lấn át dữ dội dòng thời sự và ngày càng có nhiều đối thủ ChatGPT chuẩn bị ra mắt. Google sắp tung ra chatbot Bard. Baidu có Ernie (viết tắt của Enhanced Representation through Knowledge Integration). Meta cũng công bố chatbot Galactica.

Tháng Chín 2022, Dân biểu Anna G. Eshoo (Dân chủ, California), đã gây áp lực buộc các quan chức liên bang phải “xử” những mô hình như trình tạo hình ảnh Khuếch tán Ổn định (Stable Diffusion) của công ty Stability AI. Anna G. Eshoo nói rằng công cụ Stable Diffusion có thể và có khả năng được sử dụng để tạo ra “hình ảnh dùng cho các chiến dịch tin giả”.

Check Point Research, một nhóm chuyên nghiên cứu thông tin tình báo và những mối đe dọa trên mạng, cũng phát hiện rằng bọn tội phạm mạng đã thử nghiệm ChatGPT để tạo phần mềm độc hại (malware). Mark Ostrowski, trưởng bộ phận kỹ thuật Check Point cho biết, kỹ thuật hack luôn đòi hỏi kiến thức lập trình ở trình độ cao, trong khi đó, ChatGPT lại “sẵn lòng” hỗ trợ những tay lập trình tập tễnh vào nghề.

(SGN)